关于 PVE SR-IOV

因为 SR-IOV 的核显直通说简单也很简单,而说复杂,也是不为过,因为会遇到很多的坑。

目前最新版本 PVE 的 SR-IOV 核显直通全网的教程也不是太多,所以,应老铁们的需求,我们一起来安装一次。

安装过程中需要变化的一些代码,我也是尽量赋值为变量,因为这样出错会少一些,那我们就一起来看看。

提示

更新日期:2025.03.20

2025 03 20 测试情况:教程支持最新 PVE 8.3.1 内核版本: 6.8.12-4-pve

本期视频

准备工作

1、大于 2G 的 U 盘(存放 Proxmox Virtual Environment ISO 镜像)

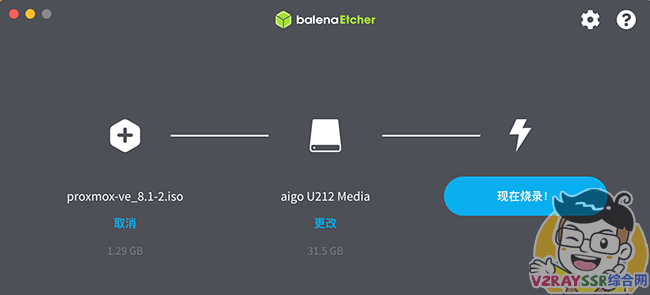

2、刻录工具( 推荐 balenaEtcher ) 点击下载

3、Proxmox Virtual Environment ISO 镜像 点击下载 最好下载 8.2.2

4、SSH 登录工具 FinalShell(支持 MacOS、Windows)点击下载

5、自行准备 OpenWRT 的固件,用于 PVE 设置过程中的外网访问(若是有其他解决办法,请忽略)

安装 PVE

刻录 ISO 镜像

下载准备工作中的刻录软件 balenaEtcher ,刻录 PVE 的 ISO 镜像到 U 盘中

设置虚拟机U盘启动

插入U盘到虚拟机,打开 BIOS 界面,根据主板的类型,设置启动方式为 U盘启动

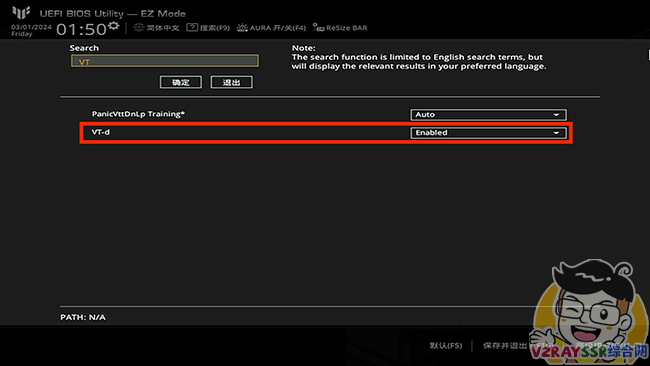

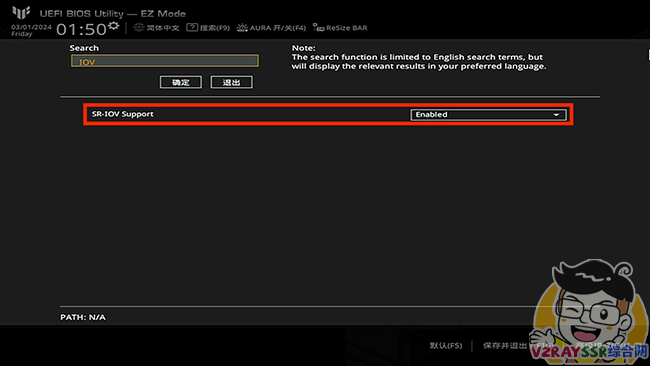

注意:个别主板需要在 BIOS 开启 SR-IOV 虚拟化核显,另外请记得 BIOS 勾选 VT-x 和 VT-d 虚拟化

安装 PVE

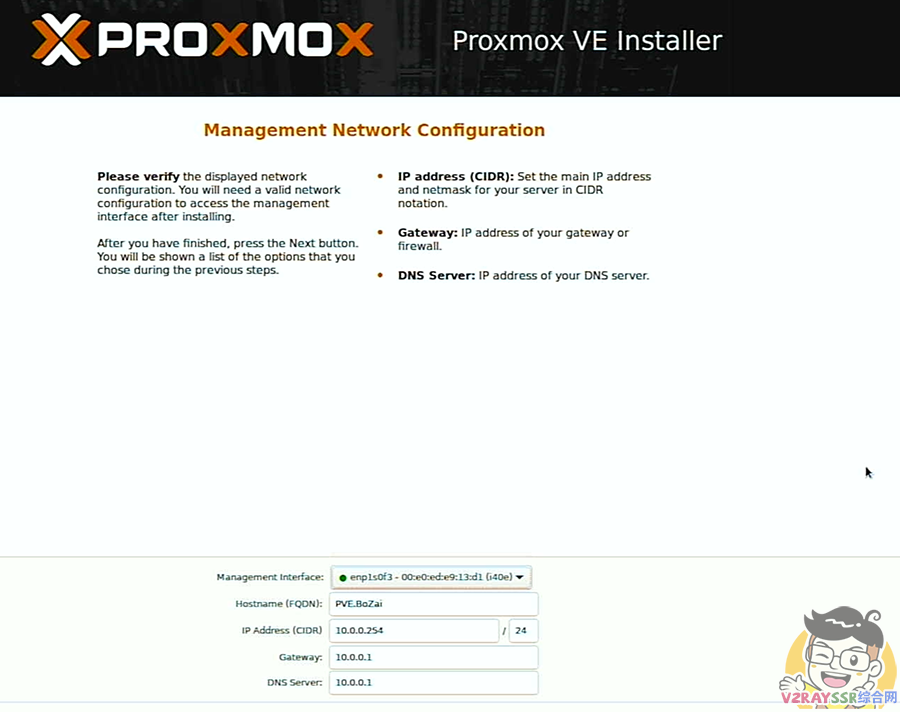

这个过程很简单,推荐安装PVE的时候,虚拟机上面只插一根网线(用于区别PVE的管理网口),记得规划好自己 PVE 的局域网 IP 即可,若是不明白,可以观看 本期视频

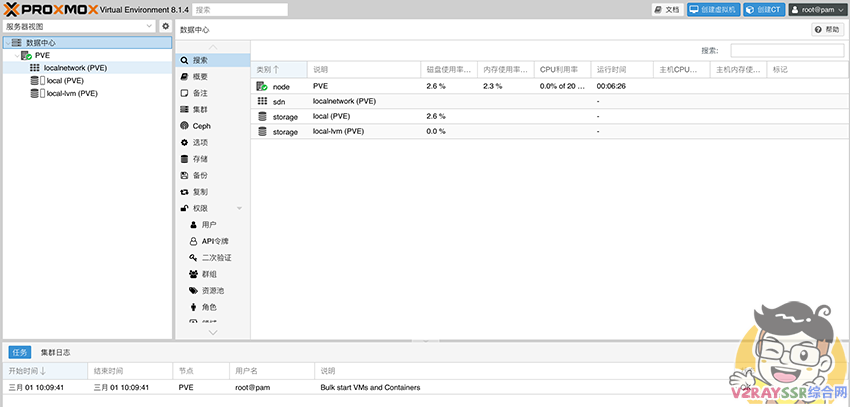

设置 PVE

浏览器访问你设置的 IP Address(CIDR) 加上端口号:https://ip:8006 (注意是 HTTPS ),进入 PVE 管理界面

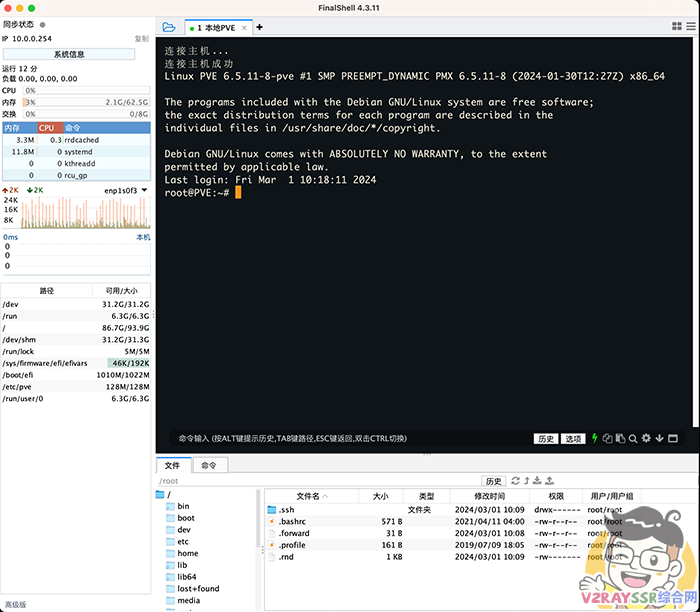

推荐使用 SSH 工具连接 PVE(当然也可以使用 PVE 自带的 Shell 网页服务)

去除 PVE 的登录弹窗

Proxmox VE 6.3 / 6.4 / 7.0 / 7.1 / 7.2 / 7.3 / 7.4 / 8.0 / 8.1 / 8.2 去掉未订阅的提示

注意:去除订阅弹窗提醒以后,必须清除浏览器的缓存数据(清理浏览器缓存)后生效

sed -i_orig "s/data.status === 'Active'/true/g" /usr/share/pve-manager/js/pvemanagerlib.js sed -i_orig "s/if (res === null || res === undefined || \!res || res/if(/g" /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js sed -i_orig "s/.data.status.toLowerCase() !== 'active'/false/g" /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js systemctl restart pveproxy

更换 PVE 源

可选,不换源也是可以的(推荐更换)

wget https://v2rayssr.com/tool/yuan.sh -O yuan.sh && chmod +x yuan.sh && ./yuan.sh

直通 PCIe 设备

目前的 PVE 版本,默认开启了 PCIE 直通。

检验 PCIE 直通结果

Shell 窗口输入 lspci ,回显如下(里面包含你所有的 PCIe 设备列表):

root@pve:~# lspci 0000:00:00.0 Host bridge: Intel Corporation Device 4640 (rev 02) 0000:00:01.0 PCI bridge: Intel Corporation 12th Gen Core Processor PCI Express x16 Controller #1 (rev 02) 0000:00:02.0 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:06.0 System peripheral: Intel Corporation RST VMD Managed Controller 0000:00:0a.0 Signal processing controller: Intel Corporation Platform Monitoring Technology (rev 01) 0000:00:0e.0 RAID bus controller: Intel Corporation Volume Management Device NVMe RAID Controller 0000:00:14.0 USB controller: Intel Corporation Alder Lake-S PCH USB 3.2 Gen 2x2 XHCI Controller (rev 11) 0000:00:14.2 RAM memory: Intel Corporation Alder Lake-S PCH Shared SRAM (rev 11) 0000:00:15.0 Serial bus controller: Intel Corporation Alder Lake-S PCH Serial IO I2C Controller #0 (rev 11) 0000:00:15.1 Serial bus controller: Intel Corporation Alder Lake-S PCH Serial IO I2C Controller #1 (rev 11) 0000:00:15.2 Serial bus controller: Intel Corporation Alder Lake-S PCH Serial IO I2C Controller #2 (rev 11) 0000:00:16.0 Communication controller: Intel Corporation Alder Lake-S PCH HECI Controller #1 (rev 11) 0000:00:17.0 System peripheral: Intel Corporation RST VMD Managed Controller 0000:00:1a.0 System peripheral: Intel Corporation RST VMD Managed Controller 0000:00:1b.0 PCI bridge: Intel Corporation Device 7ac0 (rev 11) 0000:00:1c.0 PCI bridge: Intel Corporation Alder Lake-S PCH PCI Express Root Port #1 (rev 11) 0000:00:1c.2 PCI bridge: Intel Corporation Device 7aba (rev 11) 0000:00:1d.0 PCI bridge: Intel Corporation Alder Lake-S PCH PCI Express Root Port #9 (rev 11) 0000:00:1f.0 ISA bridge: Intel Corporation Z690 Chipset LPC/eSPI Controller (rev 11) 0000:00:1f.3 Audio device: Intel Corporation Alder Lake-S HD Audio Controller (rev 11) 0000:00:1f.4 SMBus: Intel Corporation Alder Lake-S PCH SMBus Controller (rev 11) 0000:00:1f.5 Serial bus controller: Intel Corporation Alder Lake-S PCH SPI Controller (rev 11) 0000:01:00.0 Ethernet controller: Intel Corporation Ethernet Controller X710 for 10GbE SFP+ (rev 02) 0000:01:00.1 Ethernet controller: Intel Corporation Ethernet Controller X710 for 10GbE SFP+ (rev 02) 0000:01:00.2 Ethernet controller: Intel Corporation Ethernet Controller X710 for 10GbE SFP+ (rev 02) 0000:01:00.3 Ethernet controller: Intel Corporation Ethernet Controller X710 for 10GbE SFP+ (rev 02) 0000:05:00.0 Ethernet controller: Intel Corporation Ethernet Controller I225-V (rev 03) 0000:06:00.0 PCI bridge: ASMedia Technology Inc. Device 1806 (rev 01) 0000:07:00.0 PCI bridge: ASMedia Technology Inc. Device 1806 (rev 01) 0000:07:02.0 PCI bridge: ASMedia Technology Inc. Device 1806 (rev 01) 0000:07:06.0 PCI bridge: ASMedia Technology Inc. Device 1806 (rev 01) 0000:07:0e.0 PCI bridge: ASMedia Technology Inc. Device 1806 (rev 01) 0000:08:00.0 Ethernet controller: Intel Corporation Ethernet Controller I226-V (rev 04) 0000:09:00.0 Ethernet controller: Intel Corporation Ethernet Controller I226-V (rev 04) 0000:0a:00.0 Ethernet controller: Intel Corporation Ethernet Controller I226-V (rev 04) 0000:0b:00.0 Ethernet controller: Intel Corporation Ethernet Controller I226-V (rev 04) 10000:e0:06.0 PCI bridge: Intel Corporation 12th Gen Core Processor PCI Express x4 Controller #0 (rev 02) 10000:e0:17.0 SATA controller: Intel Corporation Alder Lake-S PCH SATA Controller [AHCI Mode] (rev 11) 10000:e0:1a.0 PCI bridge: Intel Corporation Alder Lake-S PCH PCI Express Root Port #25 (rev 11) 10000:e0:1b.0 System peripheral: Intel Corporation RST VMD Managed Controller 10000:e0:1b.4 PCI bridge: Intel Corporation Device 7ac4 (rev 11) 10000:e1:00.0 Non-Volatile memory controller: MAXIO Technology (Hangzhou) Ltd. NVMe SSD Controller MAP1202 (rev 01) 10000:e2:00.0 Non-Volatile memory controller: MAXIO Technology (Hangzhou) Ltd. NVMe SSD Controller MAP1602 (rev 01) 10000:e3:00.0 Non-Volatile memory controller: MAXIO Technology (Hangzhou) Ltd. NVMe SSD Controller MAP1202 (rev 01) root@pve:~#

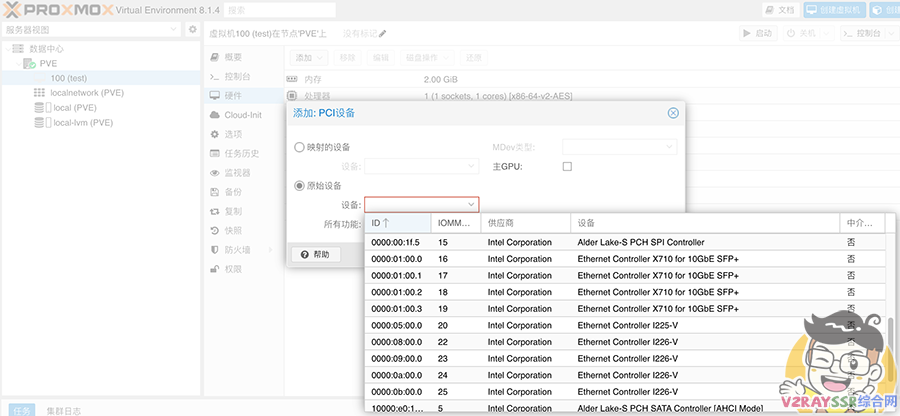

新建虚拟机,参数随意,用于检测 PCIE 是否直通成功。

来到虚拟机的硬件界面,点击添加 PCI 设备,选择 原始设备,参看 PCIE 设备列表,查看网口是否被划分为单个设备。

以上,为直通成功,可以看到两张四口的网卡,被划分为了八个网口。

开启核显的 SR-IOV

什么是SR-IOV?这里引用 Oracle 的说明

SR-IOV 技术是一种基于硬件的虚拟化解决方案,可提高性能和可伸缩性。SR-IOV 标准允许在虚拟机之间高效共享 PCIe(Peripheral Component Interconnect Express,快速外设组件互连)设备,并且它是在硬件中实现的,可以获得能够与本机性能媲美的 I/O 性能。SR-IOV 规范定义了新的标准,根据该标准,创建的新设备可允许将虚拟机直接连接到 I/O 设备。

简单来说,允许将一个PCIe设备虚拟化成多个设备,且每个虚拟化出来的设备都可以获得与物理设备相近的性能

如果显卡开启SR-IOV就可以给多台虚拟机同时配上显卡

网卡之类的设备也支持SR-IOV,但是不如显卡这么有用(毕竟虚拟化出来的网卡性能也没差多少,还不需要自己安装驱动)

在以下的 SR – IOV 设置中,请开启 PVE 的外网访问(需要访问 GitHub ),博主是已经提前在 PVE 部署了 OpenWRT,用于旁路由。

具体命令如下,若是不太明白,推荐先观看 本期视频

# 2025-03-20 支持内核 6.8 # 保证 PVE 为科学网络 # 2025 03 20 测试情况:教程支持最新 PVE 8.3.1 内核版本:6.8.12-4-pve # 更换源(可选,但是推荐更换) wget https://v2rayssr.com/tool/yuan.sh -O yuan.sh && chmod +x yuan.sh && ./yuan.sh # 更新源 apt update -y # 后续避免升级内核 apt install build-* dkms git sysfsutils -y apt install proxmox-headers-6.8 proxmox-kernel-6.8 # 下面的命令若是失效,请留意作者项目地址的更新地址 https://github.com/strongtz/i915-sriov-dkms wget -O /tmp/i915-sriov-dkms_2025.02.03_amd64.deb "https://github.com/strongtz/i915-sriov-dkms/releases/download/2025.02.03/i915-sriov-dkms_2025.02.03_amd64.deb" dpkg -i /tmp/i915-sriov-dkms_2025.02.03_amd64.deb # i915.max_vfs=3 这个 3 是需要虚拟的核显数量,需要和下面命令中的 sriov_numvfs = 3 数量一致 sed -i '/^GRUB_CMDLINE_LINUX_DEFAULT/c\GRUB_CMDLINE_LINUX_DEFAULT="intel_iommu=on i915.enable_guc=3 i915.max_vfs=3 module_blacklist=xe"' /etc/default/grub update-grub update-initramfs -u -k all lspci | grep VGA # 请记录当前的核显ID,修改下行的ID后执行下面的代码。 # 下面的 sriov_numvfs = 3 是虚拟的核显数量,需要和上面命令中的 i915.max_vfs=3 数量一致 echo "devices/pci0000:00/0000:00:02.0/sriov_numvfs = 3" > /etc/sysfs.conf reboot

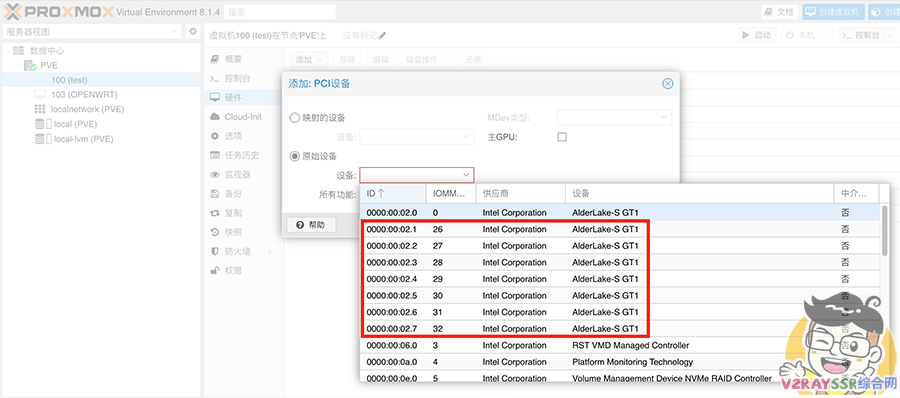

重启之后,在 SHELL 窗口输入 lspci | grep VGA ,回显如下所示,SR-IOV 开启成功,成功虚拟出了 7 个核显。

root@pve:~# lspci | grep VGA 0000:00:02.0 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.1 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.2 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.3 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.4 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.5 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.6 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) 0000:00:02.7 VGA compatible controller: Intel Corporation AlderLake-S GT1 (rev 0c) root@pve:~#

上图中的 26 — 32 为 SR-IOV 虚拟出来的 7 个核显。

后记

那以上就是目前最新 PVE 8.1.4 版本的安装、PCIe 以及 SR-IOV 核显直通的最简单的调试办法了。

若是按照教程的操作来,相信你一定也是成功安装并已经完成调试了。

后续如果大家需要的话,我也会为大家带来更多PVE虚拟机上面的一些实用功能,比如,Emby 共用核显、完美群辉的安装、Windows11 在 PVE 上面的表现等

[…] 20250320已更新:最新保姆级PVE8安装教程!虚拟机PCIE设备及SR-IOV核显直通,最… […]

学习学习 谢谢分享

学习学习 谢谢分享

视频里的操作命令怎么没有啊

同求

波仔能出一期核显直通HDMI输出的视频吗?我的配置铭瑄B760ITX D5 WIFI,CPU是13400,按照别人的教程做无论如何都驱动不了核显。只要装完核显驱动后设备管理器里就停止运行,错误43。如果能够HDMI输出的同时还能让EMBY共用核显解码的话那就太棒了。

波仔,按照你这个教程走完,直通和sr-iov都做完了,直通可以看到核显,sr-iov在硬件中可以看到7个核显,但是当我把核显挂在虚拟机上之后,虚拟机启动不了,错误提示是“TASK ERROR: no pci device info for device ‘0000:00:02.1’”,系统信息是“pve8.1.4 内核Linux 6.5.11”,求教这种情况要如何处理?